网站优化过程中百度抓取器爬虫工作原理,网站抓取建设指南!

首要百度的抓取器会和网站的主页进行交互,拿到网站主页之后会对页面进行了解,了解包含(类型、价值计算),其次会把网站主页的一切超链接提取出来。

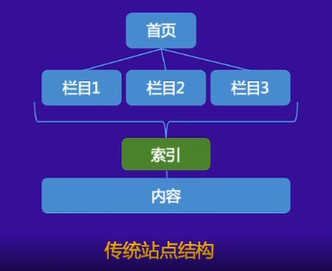

如上图所示,主页的超链接被称为“后链”,比及下一轮抓取的时候,抓取器会持续和这些超链接的页面进行交互,拿到页面进行提炼,依次不断一层一层的抓取,这就构成了抓取环路。

一、抓取友好性优化

1、URL标准

任何一个资源都是通过URL来抓取的,URL相关于网站的门牌号,那么URL的规划就十分重要了。尤其是如上图所示,“待抓URL”的环境,爬虫在主页的时候,并不知道URL是什么样子。

优秀的URL的特点是干流的、简略的,竟或许不要去做一些非干流的款式,让人看起来很直观的URL。

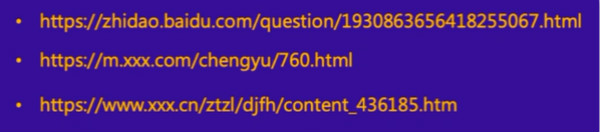

优秀URL示例:

如上图所示,第一条是百度知道的链接,整个链接分红三段,第一段是网站的站点,第二段是资源类型,第三段是资源的ID。这种便是十分简略,而且爬虫看起来十分优质的URL。

如上图所示,第三条相对百度知道多了一个段,首要第一段是网站的站点,第二段是站点的一级目录,第三段是站点的二级目录,最终一段是站点的内容ID。像这种的URL也是符合标准的。

不友好的URL示例:

如上图所示,这种链接一看就很长很杂乱,有经验的站长都看得出,这种URL包含了字符,这个URL内包含了文章的标题,导致URL偏长,一个偏长的URL相对比简略的URL是不占优势的,百度站长渠道的规矩有明确的提到URL不能超过256字节,个人主张URL长度控制在100字节之内,100个字符满足展示出URL的资源了。

如上图所示,这段URL包含计算参数,或许会导致重复抓取,糟蹋站点权益,所以竟或许不运用参数,假如必定要运用参数,那么也能够保存必要参数,参数字符竟或许运用惯例的连接符,比方“?”、“&”,防止非干流连接符。

2、合理发现链路

爬虫是从主页开端一层一层抓取的,所以就需求做好主页与资源页的URL联系。这样爬虫抓取相对而言比较省力。

如上图所示,从主页到具体内容的超链路径联系叫做发现链路,现在大多数移动站没有太注意发现链路的联系,所以导致爬虫无法抓取到内容页。

如上图所示,这两个站点是移动网站常见的建站方法,从发现链路的视点来讲,这两类站点是不友好。

Feed流引荐:

大多数做feed流的站点后台是有十分多的数据,用户不断的刷会有新的内容呈现,但你刷新的次数再多,或许也只能刷到1%左右的内容,而爬虫相当于一个用户,爬虫不或许做到以这种方法将网站一切的内容都爬取到,所以就会导致一些页面爬虫不到,即便你有100万的内容,或许只能抓取到1-2万。

仅有查找进口:

如上图所示,主页只要一个查找框,用户需求输入关键词,才干找到对应的内容,但爬虫不或许做到输入关键词然后再去爬取,所以爬虫只能爬取到主页后,就没有后链了,天然抓取和录入就会不理想。

处理方案:

索引页下的内容按发布时刻逆序排序的,这样做有一个优点,查找引擎能够通过索引页即便的抓取到你网站最新的资源,另外新发布的资源要实时在索引页同步,很多纯静态的网页,内容更新了,可是主页(索引页)却没有出来,这样会导致查找引擎通过索引页无法即便的抓取到最新的资源,第三个点是后链(最新文章)的URL需求直接在源码在露出,便利查找引擎抓取,最终便是索引页不是越多越好,有少数优质的索引页就满足了,比方长城号,基本上只利用主页来做索引页。

最终这儿和咱们说一个更高效的处理方案,那便是直接通过百度站长资源渠道去自动提交资源,这样查找引擎能够绕过索引页直接抓取到最新资源,这儿需求注意两个点。

Q:资源提交是不是越多越好?

A:录入效果的核心永远是内容质量,假如很多提交低质、泛滥资源会导致惩罚性打击。

Q:为什么提交了一般录入但没有抓?

A:资源提交只能加速资源发现,不能确保短时刻内抓取,当然百度方面表示,算法在持续优化,让优质的内容更快得到抓取。

3、拜访友好性

抓取器要和网站进行交互,要确保网站的安稳的,抓取器才干够正常的爬取。那么拜访友好性主要包括以下几个方面。

拜访速度优化:

加载时刻主张控制在2S以内,那么无论是用户仍是爬虫,关于翻开速度更快的网站,都会愈加青睐,其次是防止非必要的跳转,这种状况虽然是少部分,但依然有网站呈现很多级的跳转,那么关于爬虫来讲,很有或许在多级跳转的同时就断开了。常见的有做了不带www的域名跳转到带WWW的域名上,然后带WWW的域名又要跳转到https上,最终替换新站,这种状况就呈现了三四级的跳转。假如呈现相似网站改版,主张直接全部跳转到新域名上。

标准http状况码:

咱们常见的301/302的正确运用,以及404的正确运用,主要是惯例的问题,用惯例的方法来处理,比方遇到无效资源,那么就运用404来做,不要用一些特别的返回状况码了。

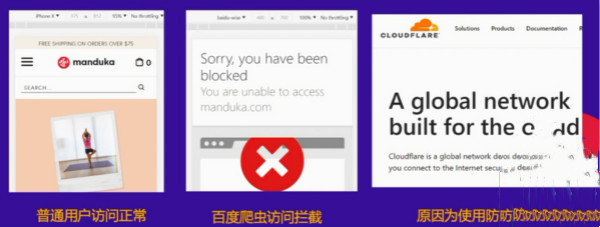

拜访安稳性优化:首要尽或许挑选国内大型的DNS服务,以确保站点的安稳性,关于域名的DNS,实际上阿里云仍是比较安稳靠谱的,那么其次是谨慎运用技术手段封禁爬虫抓取,假如说有特定资源不期望在百度上展示,那么能够选用robots来屏蔽,比方说网站的后台链接,大多数都是通过robots屏蔽的。假如说抓取频次太高,导致服务器压力过大,影响用户正常拜访,那么能够通过资源渠道的东西降低抓取频率。其次是防止防火墙误封禁爬虫抓取,那么这儿主张咱们能够把查找引擎的UA加入到白名单。最终一点是服务器的安稳性,特别是在短时刻内提交很多优质资源,这个时候必定要重视服务器安稳性,因为当你提交很多资源后,爬虫会随之添加,这个时候会不会导致你服务器压力过大而打不开,这个问题是需求站长重视的。

如上图所示,这三个例子便是第三方防火墙阻拦的一个状况,当正常用户翻开是这个状况的时候,查找引擎抓取的时候,也会处于这个状况,所以假如遇到CC或许DDOS的时候,咱们开启防火墙的条件,必定要放开查找引擎的UA。

4、问答环节

Q:新站会不会有一个的抓取限制?

A:关于任何一个新站来讲,都没有抓取限制,不过去年开端,咱们已经开端对新站有一个扶持,让你的网站,先在百度上录入起来。然后再进行一个价值判别,那么如何让百度知道你是一个新站,有两个捷径,第一个是去百度资源渠道提交,第二个点是去工信部做ICP的存案,咱们能够从工信部拿到ICP存案的数据,存案之后咱们就知道有人建了一个新的站点,这样就能够给新站一个基础的流量扶持。

Q:每个站点蜘蛛抓取的配额都会有调整,大概多久调整一次?

A:的确会有调整,关于新资源会与你抓取频率相关,关于旧资源会与你内容质量相关,假如说新资源的质量有改变,那么抓取频率也会有改变,网站的规模有改变,那么抓取的频率也会有改变,假如说有很大的改版,那么抓取频率相对而言也会有改变。

Q:网站降权能不能康复?

A:网站降权康复的条件是咱们会对网站进行从头评价,查看网站是不是有整改,假如有整改是不是做了404,而且有提交到资源渠道,假如说彻底符合要求后,查找引擎会通过评价后,对没有违规的网站进行康复。

Q:新站点是不是有查核期?

A:对咱们来讲是没有一个查核期这么一个东西,咱们前面也讲到了,竟或许会对新站的一个流量扶持,假设一个新站点流量扶持1-2个月今后,发现网站持续保持这种状况,那么就不会有一个太大的调整,当发现网站质量有明显的提高,那么咱们也会相应的提高百度排名。

Q:百度对外国的服务器和国内的服务器有没有区别对待?

A:战略视点上来件,没有硬性区别对待,可是很多外国的服务器对国内部分区域封禁,以及国外服务器网站存案的视点上来讲,国内的服务器都具有优势。

Q:新站旧域名是不是更有优势?

A:假如说老域名和新站是相同的内容,的确在起步阶段有必定的优势,但仅仅是起步阶段,后期仍是要看内容的质量,特别要注意的是,假如说老域名的职业和你新网站的内容不相关,即便是所谓高权重的老域名,也会拔苗助长。百度会认为你今日做这个,明日做那个,效果还不如从头做一个新域名。